Содержание статьи

Индексация сайта – это процесс обхода сайта краулерами и добавления его в базу поисковых систем в особом виде. Поэтому те страницы, которые есть в выдаче и называются проиндексированными. Этот процесс является очень важным для работы и продвижения сайта, поскольку при неправильных указаниях поисковым роботам, в выдачу могут попадать страницы с личными данными, дубли и другие мусорные страницы.

В процессе индексации краулеры собирают данные со страниц ресурса, оценивают контент (текстовый и графический), ссылочную массу, мета-теги и структуру. От совокупного качества оптимизации сайта (внешней и внутренней) зависит итоговый результат. Чем больше «баллов» по ходу проверки получает определенная страница, тем выше она будет отображаться в поисковой выдаче.

Индексация сайта играет большую роль и для владельцев сайтов по той причине, что дает возможность привлекать новых пользователей и увеличивать посещаемость ресурса. Чем больше веб-страниц проиндексировано в поисковике, тем выше вероятность привлечения целевой аудитории и увеличения органического трафика.

Добавление сайта в индекс поисковых систем

Для того чтобы поисковик знал о появлении нового сайта, его нужно уведомить об этом особым образом. Для этого есть несколько способов, которые могут отличаться скоростью или эффективностью. Рассмотрим их ниже.

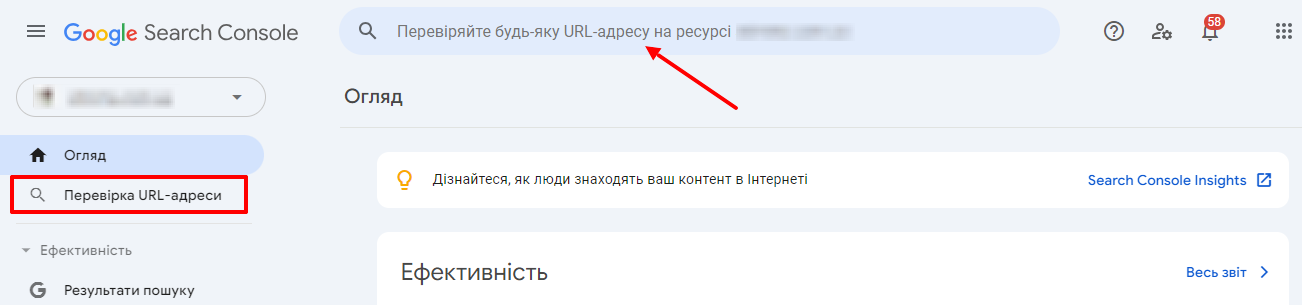

Добавление с помощью инструмента проверки URL в Google Search Console

С помощью этого инструмента в GSC есть возможность запросить индексирование страницы поисковым роботом и узнать, на каком этапе находится этот процесс (который может занять от одного дня до 2 недель). Необходимо учитывать, что за один день можно отправить до 10 запросов на индексирование, и отправка такого запроса вовсе не гарантирует, что страница появится в индексе Google.

Для проверки вставляете адрес сайта в строку:

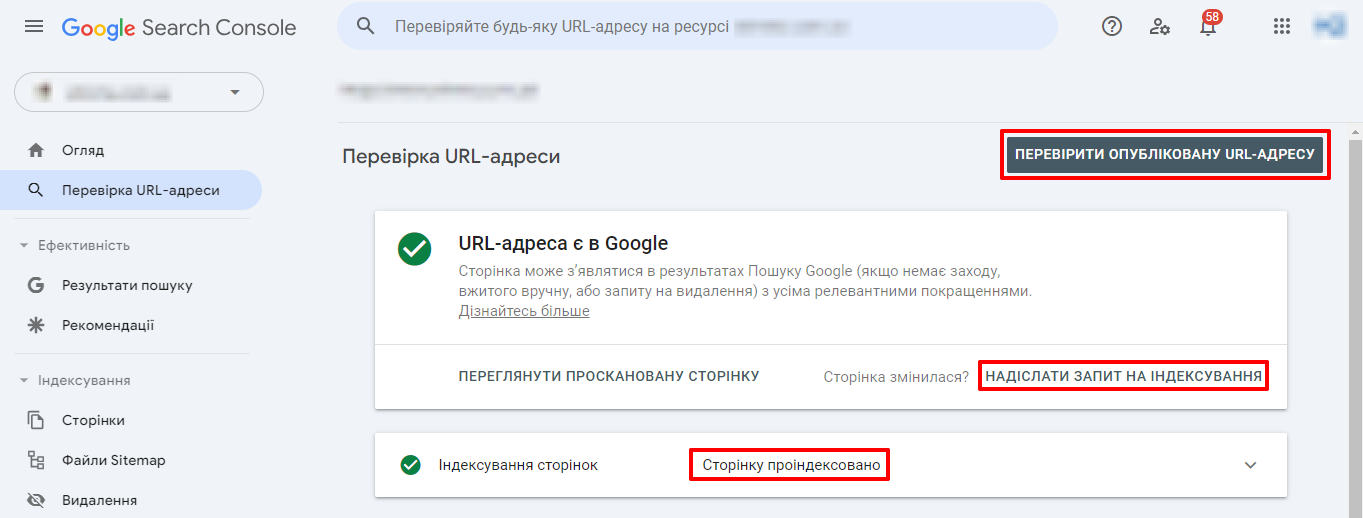

Затем нажимаете «Проверить опубликованный URL-адрес». И если его в индексе еще нет, жмете «Запросить индексирование». И в том случае, если ошибок обнаружено не будет, страница добавится в очередь.

Добавление внешней ссылки на ваш сайт

Данный метод заключается в том, что на определенном ресурсе, у которого хорошая индексируемость, вы размещаете ссылку на свой сайт, и краулеры, при обходе сайта-донора, увидят ссылку на непроиндексированный сайт и добавят его в очередь. Лучше всего размещаться на популярных информационных или новостных порталах, поскольку у них, чаще всего, роботы могут бывать на сайте каждые 2-3 часа. Такой способ добавления сайта менее быстрый и менее надежный, но все же также действенный.

Добавление внешней ссылки с социальных сетей

Данный метод стал достаточно актуальным несколько лет назад, когда поисковик начал в полной мере оценивать страницы социальных сетей как полноценные ресурсы. Необходимо просто добавить ссылку на сайт. Но очень важным нюансом есть то, что ссылка должна быть именно прямая, поскольку ссылка через редирект не даст никакого результата.

Индексируемость сайта: как узнать

Чтобы понять, насколько эффективно проиндексирован сайт, необходимо знать количество страниц на сайте, которые должны быть проиндексированы, и страницы, которые уже в были обойдены роботами.

I= N1 (проидексированные страницы) / N2 (все необходимые страницы сайта) * 100%

Значение переменной N1 можно узнать несколькими способами:

- вставив в поисковую строку следующий код «site:site.ua» и долистав до последней страницы результатов поиска, посмотреть реальное количество страниц в индексе. Необходимо для каждого поисковика это делать отдельно.

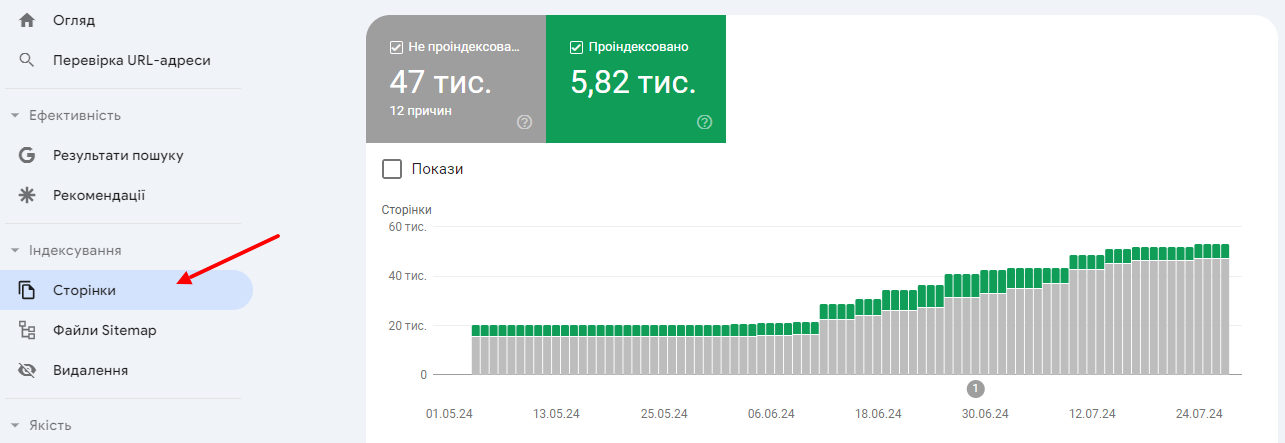

- второй способ подходит только для Google. Вы можете посмотреть количество проиндексированных страниц в SearchConsole в разделе «Индексация» подраздел «Страницы», там указывается количество проиндексированных страниц.

Значение переменной N2 можно пересчитать:

- по количеству адресов в карте сайта;

- по количеству адресов в выгрузке сайта после удаления мусорных страниц.

Например: проиндексированных страниц в Гугл – 330. А всего страниц на сайте 350. Тогда получается это так:

Если процент индексации менее 50%, то это является очень плохим показателем и означает, что у сайта есть большие проблемы с индексацией, и нужен глубокий анализ причин.

Если показатель колеблется от 50% до 80% тогда на сайте проблемы с индексацией незначительные и, скорее всего, это связано с неправильной настройкой robots.txt и sitemap.xml.

Если показатель колеблется от 80% до 100%, тогда индексация сайта нормальная. И никаких кардинальных правок проводить не нужно.

Если данный коэффициент более 100%, то, вероятнее всего, на сайте присутствуют проблемы с неправильной настройкой robots.txt или не полной картой сайта.

Как улучшить индексируемость сайта?

Для того, чтобы максимально ускорить индексацию сайта, необходимо правильно настроить взаимодействие сайта с поисковыми роботами и предельно четко им показывать, что нужно сканировать, а что нет. Для этого используются различные методы и функционал. Для запрета индексирования существует 3 доступных способа, отдельно о каждом поговорим ниже. Для того, чтобы показать роботам, что нужно индексировать, составляются специальные списки адресов, называемые картами сайта, их тоже опишем ниже.

Файл robots.txt

С помощью директив в файле вы можете дать рекомендации поисковым роботам, что нужно индексировать, а что нет. Но страницы, закрытые в robots.txt, могут попадать в выдачу, поскольку указания имеют совещательный характер при обходе страниц. Также если появились мусорные страницы в выдаче, удалить их не получится, их просто нужно согнать в «сопли» (Supplemental index или results) – дополнительная выдача Гугл с низкокачественными страницами. Для того, чтобы страницы пропали из индекса и краулеры их точно не индексировали, необходимо применять другие методы.

Использование корректных основных инструкций в файле robots.txt дает возможность следить за процессом индексации и повышать доступность и видимость вашего ресурса в поисковике. Это один из основных инструментов для оптимизации сайта и получения хороших результатов в поисковой выдаче.

МЕТА-тег «Robots»

Данный метод закрытия страниц от индексирующих роботов уже является не рекомендательным, а обязательным к исполнению. Используя meta robots можно удалять страницы из поисковой выдачи, чего не позволял robots.txt. Также с помощью данного тега можно не только управлять индексированием содержимого, а также и переходами по внутренним и внешним ссылкам.

Список директив, которые применяются:

- Index – дает разрешение на индексирование страницы

- Noindex – закрывает доступ роботам к странице

- Follow – разрешает переходить по всем ссылкам на странице

- Nofollow – запрещает переходы по гиперлинкам

- All – разрешает индексировать и переходить по ссылкам

- None – запрещает обход страницы и переходы по линкам

То есть:

<meta name=“robots” content=“index,follow”> = <meta name=“robots” content=“all”> – разрешается индексация и переходы;

<meta name=“robots” content=“noindex,follow”> – нельзя загружать содержимое страницы, но можно переходить по ссылкам;

<meta name=“robots” content=“index,nofollow”> – можно загружать контент страницы, но переходы запрещены;

<meta name=“robots” content=“noindex,nofollow”> = <meta name=“robots” content=“none”> – запрещается все.

Применение http-заголовка X-Robots-Tag

Данный способ управления является самым продвинутым и самым гибким, поскольку дает указания по работе со страницей сразу при загрузке http ответа сервера. Особенностью есть то, что применяется он не только для html-страниц, но и для любых файлов: картинок, видео, документов и т.д. С помощью meta robots можно закрывать лишь html-страницы.

Директивы у X-Robots-Tag такие же, как и у мета-тега robots:

- index;

- noindex;

- follow;

- nofollow;

- all.

Индексирование страниц по карте сайта

Карта сайта — это файл со списком всех страниц сайта, которые должны быть проиндексированы и добавлены в поисковую выдачу. С ее помощью упрощается работа поискового робота. Он не просто будет переходить по внутренним ссылкам, при этом расходуя время, краулинговый бюджет и мощности сервера, а посещать именно те страницы, которые указаны в карте сайта.

Также очень важно, что в карте сайта можно указывать приоритет сканирования и дату последнего изменения. Это очень важные параметры для большого сайта или ресурса с постоянно изменяющимся контентом. Например, если указана дата редактирования (<lastmod>), зачем роботу обходить заново страницы, которые не менялись с последнего раза, лучше выгружать те, на которых менялся контент. Либо если указан приоритет (<priority>), тогда краулер будет обходить в первую очередь страницы с более высоким приоритетом, при прочих равных условиях.

Например, у нас есть такая карта сайта:

URL1

2018-01-02T12:41:56+01:00

1.0

URL2

2018-01-02T12:41:56+01:00

0.8

URL3

2018-01-05T12:41:56+01:00

0.8

Тогда первым будет индексироваться страница URL3 (изменялась позже всех), далее за ней – URL1 (поскольку приоритет 1).

Подготовка и отправка карты сайта представляют собой значимую стратегию, способствующую ускорению и упрощению процесса индексации вашего веб-ресурса поисковыми системами. Обновление карты сайта со стабильной регулярностью также обеспечивает возможность следить за присутствием вашего сайта в результатах поиска и повышать его видимость для пользователей.

Подведем итоги

В статье мы рассмотрели, что такое индексация и методы ее улучшения. В ходе рассмотрения темы становится ясно, что количество проиндексированных страниц напрямую влияет на привлечение целевой аудитории и органический трафик. Оптимизация контента, улучшение структуры сайта и использование правильных метатегов способствуют более полному индексированию страниц поисковыми системами. Понимание этих аспектов поможет сайту эффективно конкурировать в онлайн-пространстве и привлекать целевую аудиторию через увеличение видимости в результатах поиска.

25/05/2024

25/05/2024  3218

3218