Зміст статті

Індексація сайту – це процес обходу сайту краулерами та додавання його до бази пошукових систем в особливому вигляді. Тому ті сторінки, які є у видачі і називаються проіндексованими. Цей процес є дуже важливим для роботи та просування сайту, оскільки при неправильних вказівках пошуковим роботам, у видачу можуть потрапляти сторінки з особистими даними, дублі та інше сміття.

У процесі індексації краулери збирають дані зі сторінок ресурсу, оцінюють контент (текстовий та графічний), посилальну масу, мета-теги і структуру. Від сукупної якості оптимізації сайту (зовнішньої та внутрішньої) залежить підсумковий результат. Чим більше «балів» під час перевірки отримує певна сторінка, тим вище вона відображатиметься у пошуковій видачі.

Індексація сайту відіграє велику роль і для власників сайтів через те, що дає можливість залучати нових користувачів та збільшувати відвідуваність ресурсу. Чим більше веб-сторінок проіндексовано в пошуковій системі, тим вище ймовірність залучення цільової аудиторії та збільшення органічного трафіку.

Додавання сайту до індексу пошукових систем

Для того, щоб пошуковик знав про появу нового сайту, його потрібно повідомити про це особливим чином. Для цього є декілька способів, які можуть відрізнятися швидкістю чи ефективністю. Розглянемо їх нижче.

Додавання за допомогою інструменту перевірки URL в Google Search Console

За допомогою цього інструменту в GSC є можливість запросити індексування сторінки пошуковим роботом і дізнатися, на якому етапі перебуває цей процес (який може зайняти від одного дня до 2 тижнів). Необхідно враховувати, що за один день можна надіслати до 10 запитів на індексування, і надсилання такого запиту зовсім не гарантує, що сторінка з’явиться в індексі Google.

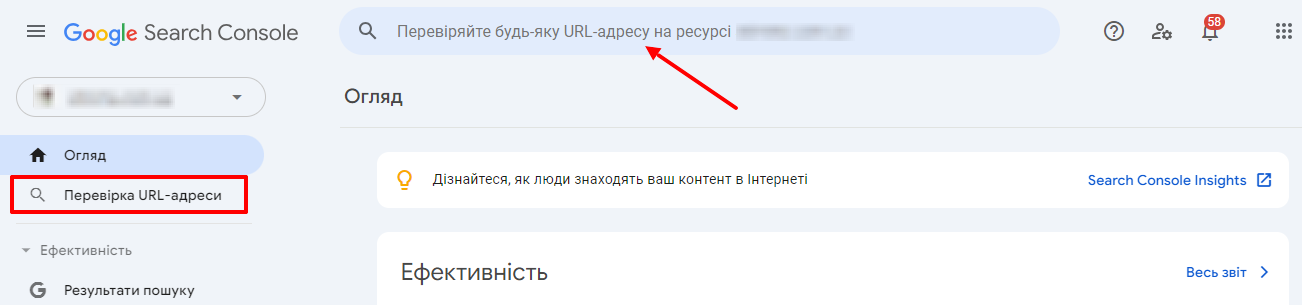

Для перевірки вставляєте адресу сайту в рядок:

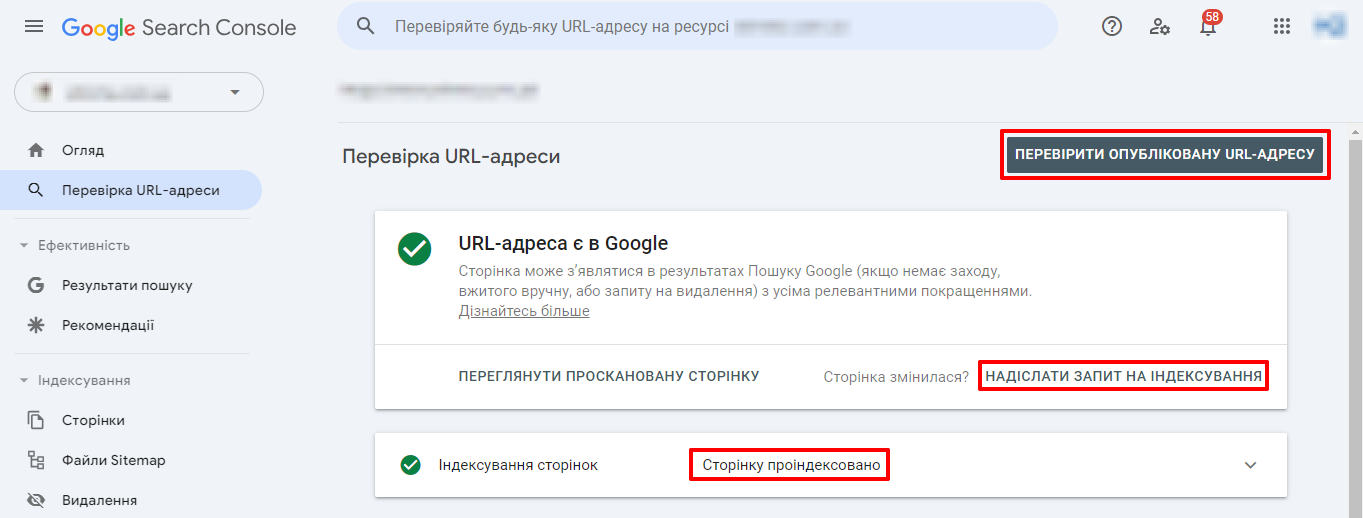

Потім натискаєте «Перевірити опубліковану URL-адресу». І якщо її в індексі ще немає, тиснете «Запросити індексування». І в тому разі, якщо помилок виявлено не буде, сторінка додасться в чергу.

Додавання зовнішнього посилання на ваш сайт

Даний метод полягає в тому, що на певному ресурсі, у якого хороша індексованість, ви розміщуєте посилання на свій сайт, і краулери під час обходу сайту-донора побачать посилання на непроіндексований сайт і додадуть його в чергу. Найкраще розміщуватися на популярних інформаційних або новинних порталах, оскільки у них, найчастіше, роботи можуть бути на сайті кожні 2-3 години. Такий спосіб додавання сайту менш швидкий і менш надійний, але все ж таки дієвий.

Додавання зовнішнього посилання із соціальних мереж

Цей метод став досить актуальним декілька років тому, коли пошуковик почав повною мірою оцінювати сторінки соціальних мереж як повноцінні ресурси. Потрібно просто додати посилання на сайт. Але дуже важливим нюансом є те, що посилання має бути саме пряме, оскільки посилання через редирект не дасть жодного результату.

Індексованість сайту: як дізнатися

Щоб зрозуміти, наскільки ефективно проіндексований сайт, необхідно знати кількість сторінок на сайті, які мають бути проіндексовані, і сторінки, які вже були обійдені роботами.

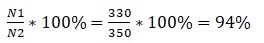

I = N1 (проідексовані сторінки) / N2 (всі необхідні сторінки сайту) * 100%

Значення змінної N1 можна дізнатися декількома способами:

- вставивши в пошуковий рядок наступний код «site:site.ua» і догорнувши до останньої сторінки результатів пошуку, переглянути реальну кількість сторінок в індексі. Необхідно для кожного пошуковика це робити окремо.

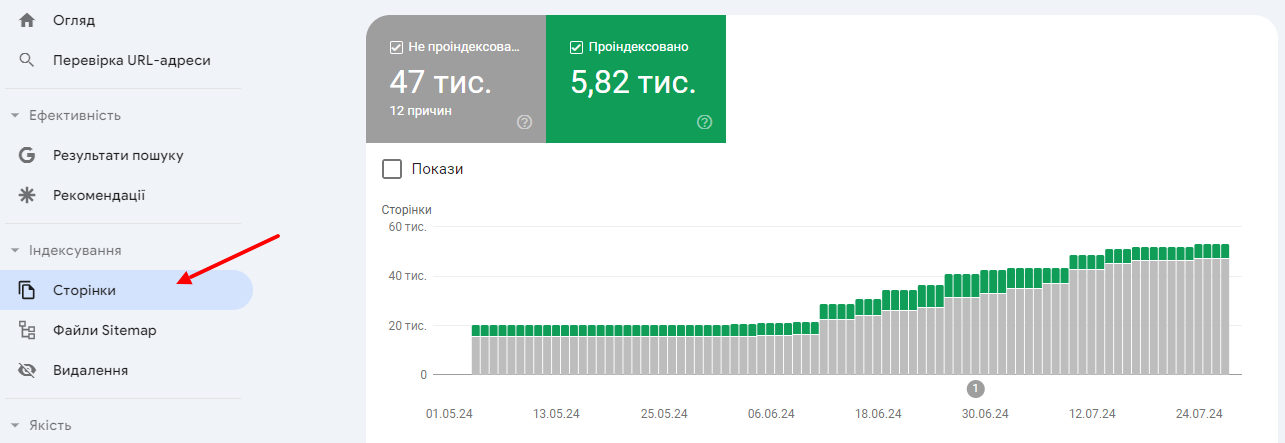

- Другий спосіб підходить тільки для Google. Ви можете переглянути кількість проіндексованих сторінок у SearchConsole у розділі «Індексування» підрозділ «Сторінки», там вказується кількість проіндексованих сторінок.

Значення змінної N2 можна перерахувати:

- за кількістю адрес у карті сайту;

- за кількістю адрес у вивантаженні сайту після видалення сторінок для сміття.

Наприклад: проіндексованих сторінок у Google – 330. А всього сторінок на сайті 350. Тоді виходить це так:

Якщо відсоток індексації менше 50%, то це є дуже поганим показником і означає, що сайт має великі проблеми з індексацією, і потрібен глибокий аналіз причин.

Якщо показник коливається від 50% до 80%, то на сайті проблеми з індексацією незначні і, швидше за все, це пов’язано з неправильним налаштуванням robots.txt і sitemap.xml.

Якщо показник коливається від 80 до 100%, тоді індексація сайту нормальна. І жодних кардинальних правок проводити не потрібно.

Якщо цей коефіцієнт більше 100%, то, найімовірніше, на сайті є проблеми з неправильним налаштуванням robots.txt або не повною картою сайту.

Як покращити індексованість сайту?

Для того, щоб максимально прискорити індексацію сайту, необхідно правильно налаштувати взаємодію сайту з пошуковими роботами і чітко їм показувати, що потрібно сканувати, а що ні. Для цього використовуються різні методи та функціонал. Для заборони індексування існує 3 доступні способи, окремо про кожен поговоримо нижче. Для того, щоб показати роботам, що потрібно індексувати, складаються спеціальні списки адрес, які називають картами сайту, їх теж опишемо нижче.

Файл robots.txt

За допомогою директив у файлі ви можете дати рекомендації пошуковим роботам, що потрібно індексувати, а що ні. Але сторінки, закриті в robots.txt, можуть потрапляти у видачу, оскільки вказівки мають дорадчий характер при обході сторінок. Також якщо з’явилися сміттєві сторінки у видачі, видалити їх не вийде, їх просто потрібно зігнати в соплі (Supplemental index або results) – додаткова видача Google з низькоякісними сторінками. Щоб сторінки зникли з індексу і краулери їх точно не індексували, необхідно застосовувати інші методи.

Використання коректних основних інструкцій у файлі robots.txt дає можливість стежити за процесом індексації та підвищувати доступність та видимість вашого ресурсу у пошуковій системі. Це один з основних інструментів для оптимізації сайту та отримання хороших результатів у пошуковій видачі.

МЕТА-тег «Robots»

Даний метод закриття сторінок від роботів, що індексують, вже є не рекомендаційним, а обов’язковим до виконання. Використовуючи meta robots, можна видаляти сторінки з пошукової видачі, чого не дозволяв robots.txt. Також за допомогою даного тега можна не тільки керувати індексуванням вмісту, а також переходами за внутрішніми та зовнішніми посиланнями.

Список директив, які застосовуються:

- Index – дає дозвіл на індексування сторінки

- Noindex – закриває доступ роботам до сторінки

- Follow – дозволяє переходити по всіх посиланнях на сторінці

- Nofollow – забороняє переходи гіперлінками

- All – дозволяє індексувати та переходити за посиланнями

- None – забороняє обхід сторінки та переходи по лінках

Тобто:

<meta name=”robots” content=”index,follow”> = <meta name=”robots” content=”all”> – дозволяється індексація та переходи;

<meta name=”robots” content=”noindex,follow”> – не можна завантажувати вміст сторінки, але можна переходити за посиланнями;

<meta name=”robots” content=”index,nofollow”> – можна завантажувати контент сторінки, але переходи заборонені;

<meta name=”robots” content=”noindex,nofollow”> = <meta name=”robots” content=”none”> – забороняється все.

Застосування http-заголовка X-Robots-Tag

Даний спосіб управління є найбільш просунутим і гнучким, оскільки дає вказівки по роботі зі сторінкою відразу при завантаженні http відповіді сервера. Особливістю є те, що застосовується він не тільки для html-сторінок, але й для будь-яких файлів: картинок, відео, документів тощо. За допомогою meta robots можна закривати лише html-сторінки.

Директиви у X-Robots-Tag такі ж, як і у мета-тегу robots:

- index;

- noindex;

- follow;

- nofollow;

- all.

Індексування сторінок по карті сайту

Карта сайту — це файл зі списком усіх сторінок сайту, які мають бути проіндексовані та додані у пошукову видачу. З її допомогою спрощується робота пошукового робота. Він не просто переходитиме за внутрішніми посиланнями, при цьому витрачаючи час, краулінговий бюджет та потужності сервера, а відвідуватиме саме ті сторінки, які вказані в карті сайту.

Також дуже важливо, що в карті сайту можна вказувати пріоритет сканування та дату останньої зміни. Це дуже важливі параметри для великого сайту або ресурсу з контентом, що постійно змінюється. Наприклад, якщо вказана дата редагування (<lastmod>), навіщо роботу обходити заново сторінки, які не змінювалися з останнього разу, краще вивантажувати ті, на яких змінювався контент. Або якщо вказано пріоритет (<priority>), тоді краулер обходитиме в першу чергу сторінки з вищим пріоритетом, за інших рівних умов.

Наприклад, у нас є така карта сайту:

URL1

2018-01-02T12:41:56+01:00

1.0

URL2

2018-01-02T12:41:56+01:00

0.8

URL3

2018-01-05T12:41:56+01:00

0.8

Тоді першим буде індексуватися сторінка URL3 (змінювалася пізніше за всіх), далі за нею – URL1 (оскільки пріоритет 1).

Підготовка та відправка карти сайту є значущою стратегією, що сприяє прискоренню та спрощенню процесу індексації вашого веб-ресурсу пошуковими системами. Оновлення картки сайту зі стабільною регулярністю також забезпечує можливість стежити за присутністю вашого сайту в результатах пошуку та підвищувати його видимість для користувачів.

Підведемо підсумки

У статті ми розглянули, що таке індексація та методи її покращення. У ході розгляду теми стає зрозумілим, що кількість проіндексованих сторінок безпосередньо впливає на залучення цільової аудиторії та органічний трафік. Оптимізація контенту, покращення структури сайту та використання правильних метатегів сприяють більш повному індексуванню сторінок пошуковими системами. Розуміння цих аспектів допоможе сайту ефективно конкурувати в онлайн-просторі та залучати цільову аудиторію через збільшення видимості у результатах пошуку.

25/05/2024

25/05/2024  3343

3343