Содержание статьи

Файл robots.txt – это специальный индексный файл, предназначенный для указания поисковым роботам на то, что можно индексировать на сайте, а что нельзя. Но как было написано в предыдущей нашей статье, для закрытия некоторых страниц на сайте нужно применять другие способы, поговорим о них далее.

Конечно, можно вбить поисковый запрос «стандартный файл robots.txt» и, зная админку, на которой написан сайт, скачать его из интернета. Но каждый сайт является уникальным, и то, что подходит одному, не обязательно подходит другому. Именно поэтому необходимо индексный файл создавать индивидуально под каждый сайт. Тогда вы точно будете уверены, что робот правильно будет обходить страницы.

Составления файла robots.txt мы всегда начинаем с выгрузки сайта. Что это такое? Это специальный файл со всеми страницами сайта и их параметрами: url, title, description, тип, ответ сервера, размер и т.д. Все это оформлено в отдельном файле в виде большой таблицы, некоторые сервисы предоставляют онлайн просмотр выгрузки. Программ для выгрузки и первичного анализа сайта просто масса, не будем акцентироваться на них, дабы не делать рекламы. Нам подойдет любая, которая выгружает адрес страницы, её тип и доступность.

Для чего нужен файл robots.txt

В первую очередь для того, чтобы увидеть полное количество страниц и файлов на сайте. Также с помощью него хорошо видно пути расположения тех или иных файлов и наличия страниц сортировок, фильтров и страниц с динамическими параметрами. Практически все современные программы показывают, открыта страница для индексирования или нет.

Нужны доступы на ftp или хостинг, чтобы посмотреть структуру папок и каталогов. Чисто теоретически, роботс можно составить и без доступов, зная админку сайта и примерную внутреннюю структура сайта. Для того, чтобы определить админку, можно воспользоваться сервисом WhatCMS.

Мы практикуем способ написания robots.txt по методу «закрой все – открой нужное», таким образом, мы минимизируем возможность попадания в поисковую выдачу мусорных страниц и файлов.

Составление файла robots.txt

Ниже рассмотрим поэтапно, как правильно составлять файл robots.txt.

Написание robots.txt

Первое, что нам нужно сделать, — это создать на компьютере обычный текстовый документ с именем robots.txt и сохранить его в кодировке utf-8. Регистр символов в названии должен быть у всех букв одинаковый – нижний. Название должно быть не Robots.txt, не ROBOTS.txt – а именно robots.txt и никак по-другому.

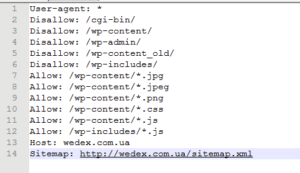

Прописываем первую команду, которая указывает директивы на обход или на игнорирование. Это команда User-agent. После неё без пробела нужно поставить «:» (двоеточие), пробел и имя конкретного робота либо * (для всех роботов). Рассмотрим наш сайт wedex.com.ua.

В своей практике мы не разделяем директивы под разные поисковики. Разделять их нужно только в том случае, когда вам необходимо для разных поисковиков индексировать различные файлы. Например, если сайт попал в одной из поисковых систем под фильтр, а по другой все отлично, тогда не стоит менять сайт, лучше скопировать его на другой домен и исправить ошибки – и таким образом у вас будет 2 сайта, дающих трафик каждый со своего поисковика.

Прописываем Allow и Disallow

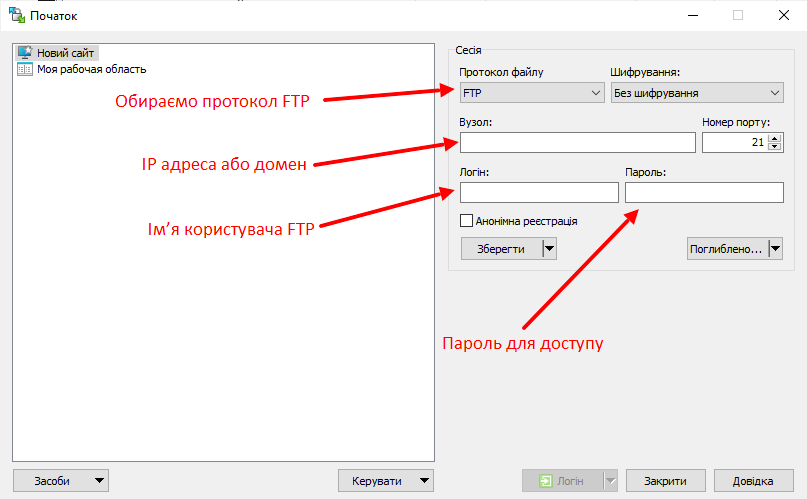

Далее заходим на ftp. Сделать это можно либо с помощью TotalCommander, либо с помощью других программ. Мы пользуемся программиой WinSCP, потому что она позволяет вносить правки в файлы «на лету».

Открываем удобную для использования программу и заполняем данные для доступа к ftp сайта.

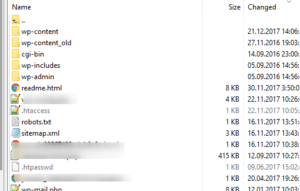

Если все сделано правильно, то увидите примерно это:

Копируем название папок и закрываем их с помощью директивы Disallow.

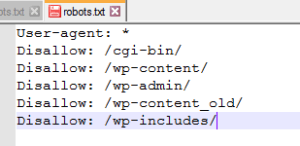

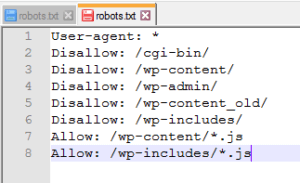

Получается примерно так:

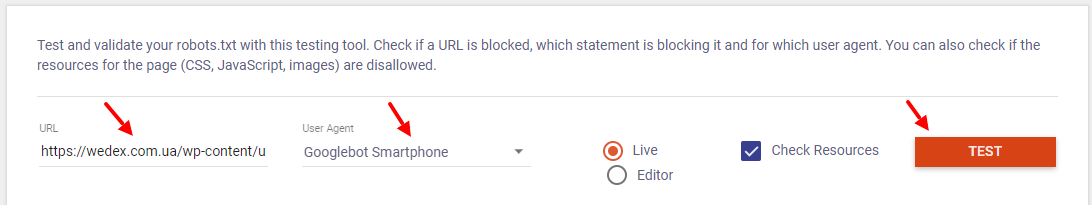

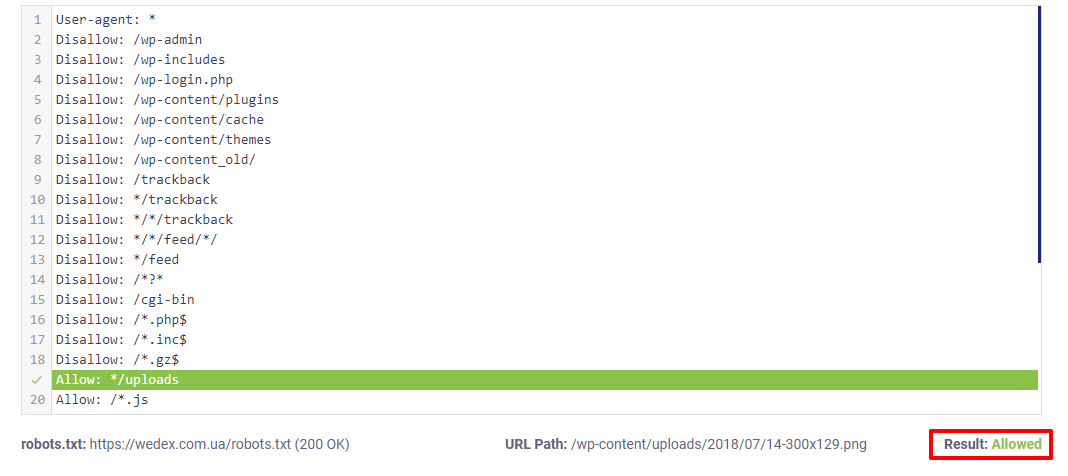

Дальше мы начинаем работать с выгрузкой сайта. Нам нужно проверить, не закрыли ли мы какие-то важные страницы. Заходим в Validator and Testing Tool для проверки, заполняем все необходимые данные и нажимаем «Test».

Добавляем адреса из выгрузки, которые нужно проверить, закрыты или открыты они к индексации. Проверить можно 1 url.

По зеленой надписи «Allowed» ниже видно, что страница открыта для индексации – это то, что нам нужно.

Далее по требованиям поисковых систем для индексации должны быть открыты все java-скрипты, css-файлы и картинки. Поэтому мы будем проверять каждый тип файлов так же, как проверяли html страницы.

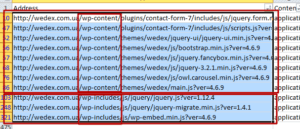

Выбираем адреса всех файлов js в файле выгрузки и проверяем их доступность так, как уже показали выше. Если файлы ява-скриптов закрыты, нужно их открыть. Находим все урлы скриптов и ищем, как можно сгруппировать.

Группируем по папкам и расширениям. Добавляем соответствующие директивы Allow в файл роботса.

Проверяем их доступность после внесения правок.

Так мы поступаем со всеми файлами: стилей – css и картинок jpg, png которые у вас есть на сайте, также можно разрешить индексацию уникальных pdf, doc, xml, и других файлов в случае необходимости. Смотрим, что у нас в конечном итоге получилось. Еще раз проверяем все, ничего ли лишнего не закрыли, и идем дальше.

Добавляем ссылку на карту сайта

Данная директива может быть необязательной, если у вас нет карты сайта. Но все же мы очень рекомендуем сгенерировать карту сайта, хотя бы автоматическим сервисом или создать вручную.

Добавляем директиву Sitemap, ставим двоеточие и пробел и вставляем ссылку на карту вашего сайта. У нас карта сайта лежит в корневом каталоге и имеет стандартное название sitemap.xml. Поэтому вот что у нас получилось в конечном итоге.

Добавление файла robots.txt на сайт

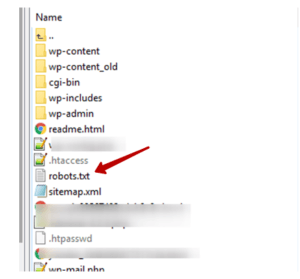

После того, как вы закончили его составление, вам нужно добавить его в коневую папку сайта. Это очень просто. Сделать это можно через программу, которой вы смотрели папки на ftp.

Просто открываете корневую папку вашего сайта и перетаскиваете туда новый роботс.

Проверка в Google SearchConsole

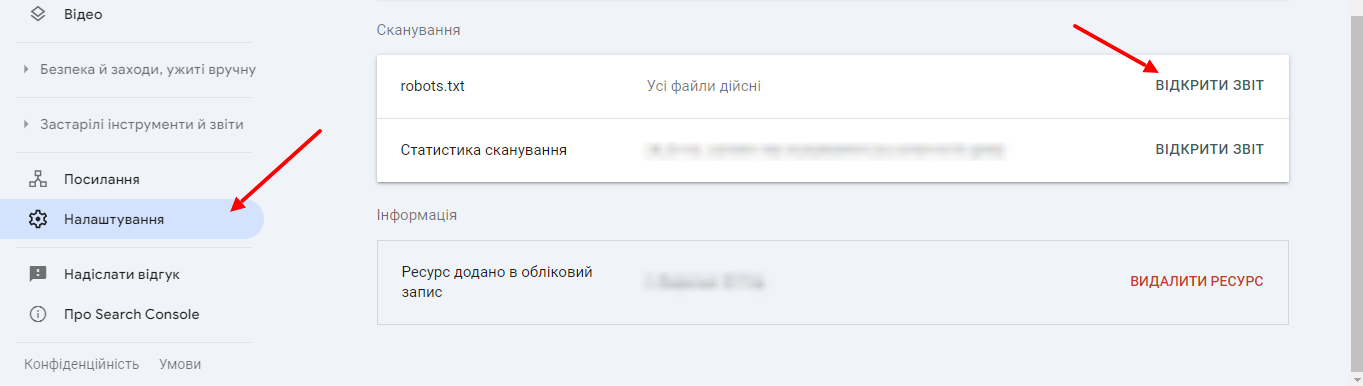

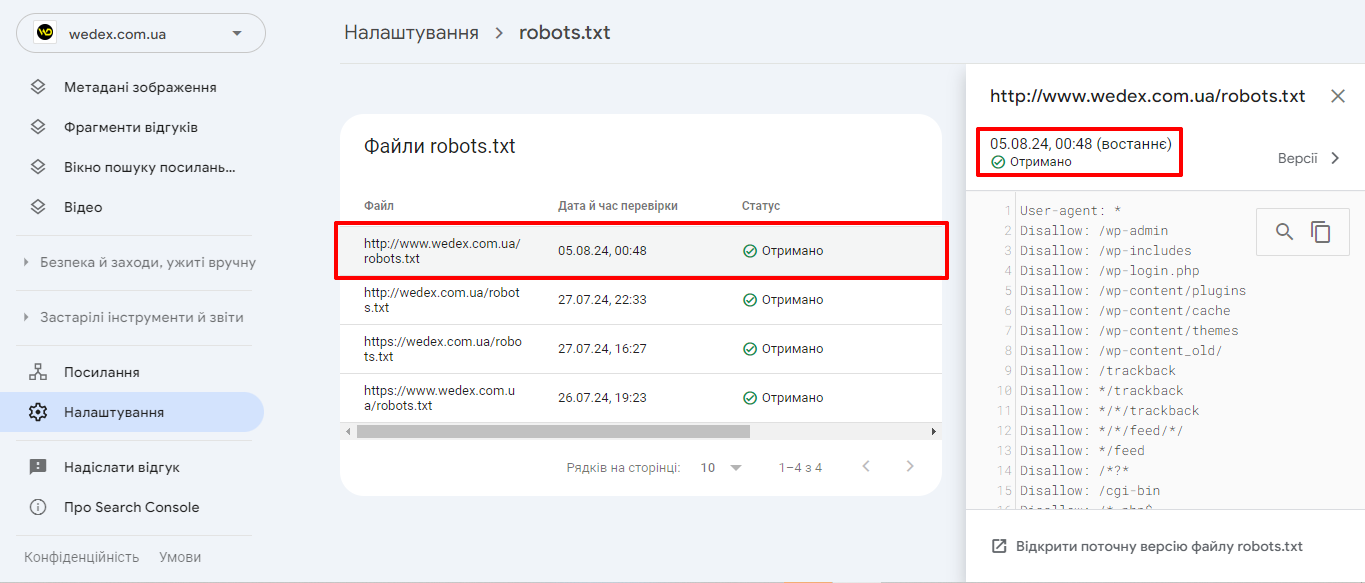

В GSC можно проверить, может ли Google обработать ваши файлы robots.txt. Для этого нужно открыть сервис под своим логином, нажать «Настройки» – «Открыть отчет».

Тут вы увидите его параметры.

По отчету robots.txt можно увидеть, какие файлы robots.txt Google нашел для 20 наиболее популярных хостов на вашем сайте, время последнего сканирования, а также любые предупреждения или ошибки.

Подведем итоги

Файл robots.txt — это важный инструмент, который играет ключевую роль во взаимодействии с поисковыми роботами и является неотъемлемой частью эффективного SEO. Он позволяет контролировать процесс индексации сайта и управлять доступом поисковых систем к определенным страницам. Правильная настройка robots.txt может значительно улучшить видимость вашего сайта в поисковой выдаче.

17/05/2024

17/05/2024  3319

3319