Зміст статті

Процес індексації є дуже важливою частиною SEO, адже без нього пошукові системи не зможуть відобразити сторінки вашого сайту в результатах пошуку. В цій статті ми розберемо, що таке індексація, як її покращити та, яких помилок варто уникати.

Але перш, ніж заглибитися в тему, давайте коротко ознайомимося з роботою пошукового алгоритму на прикладі Google. Нижче виділено основні моменти:

- Сканування (Crawling) – це процес, під час якого пошукові системи знаходять і збирають інформацію про веб-сторінки в інтернеті. Уявіть собі маленьких роботів, які пересуваються по сайтах, переходячи з однієї сторінки на іншу за допомогою посилань. Вони аналізують їх вміст і зберігають цю інформацію в базі даних, яка називається індексом.

- Індексація (Indexing) – це етап, на якому інформація про знайдені сторінки зберігається та організовується в індексі. Це дозволяє пошуковому алгоритму швидко знаходити та відображати релевантну інформацію на запити користувачів. Наприклад, коли ви вводите запит «купити ноутбук», то пошуковий алгоритм звертається до свого індексу, знаходить сторінки про ноутбуки і відображає їх у результатах пошуку.

- Ранжування (Ranking) – після індексації Google визначає порядок показу сторінок, враховуючи велику кількість сигналів: ключові слова, якість контенту, авторитетність домену, зручність у використанні та інші.

Якщо підсумувати, то індексація – це процес під час якого пошукові роботи (павуки) шукають нові сторінки в інтернеті, аналізують їх вміст та зберігають цю інформацію в своєму індексі.

Варто зауважити, що роботи час від часу повертаються до вже проіндексованих сторінок, щоб перевірити наявність змін та оновити інформацію.

Як перевірити індексацію сайту?

Перевірка індексації є важливим моментом. В цьому розділі ми розглянемо ефективні методи та інструменти, які допоможуть вам дізнатися, чи знаходиться ваш інтернет-ресурс в індексі пошукових систем.

Google Search Console

- Зареєструйтесь, якщо у вас немає акаунту, та додайте свій сайт.

- Перейдіть до розділу «Coverage» у меню ліворуч. Тут ви зможете побачити кількість проіндексованих сторінок, а також наявні помилки.

- Для перевірки окремих сторінок можете використовувати інструмент «URL Inspection», він також знаходиться в меню з лівого боку.

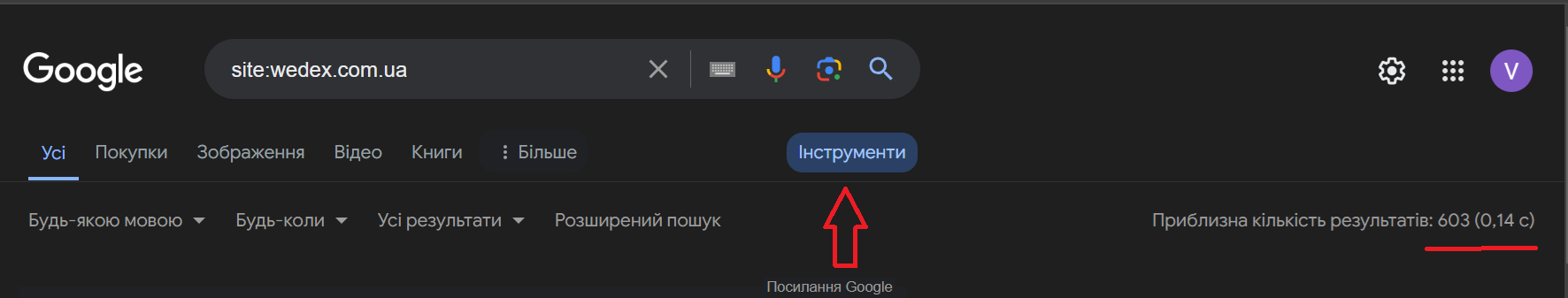

Використовуйте оператор «site»

У пошуковому рядку введіть «site:yourdomain.com», замінивши «yourdomain» на свій домен. Далі натисніть на «Інструменти», щоб побачити кількість проіндексованих сторінок.

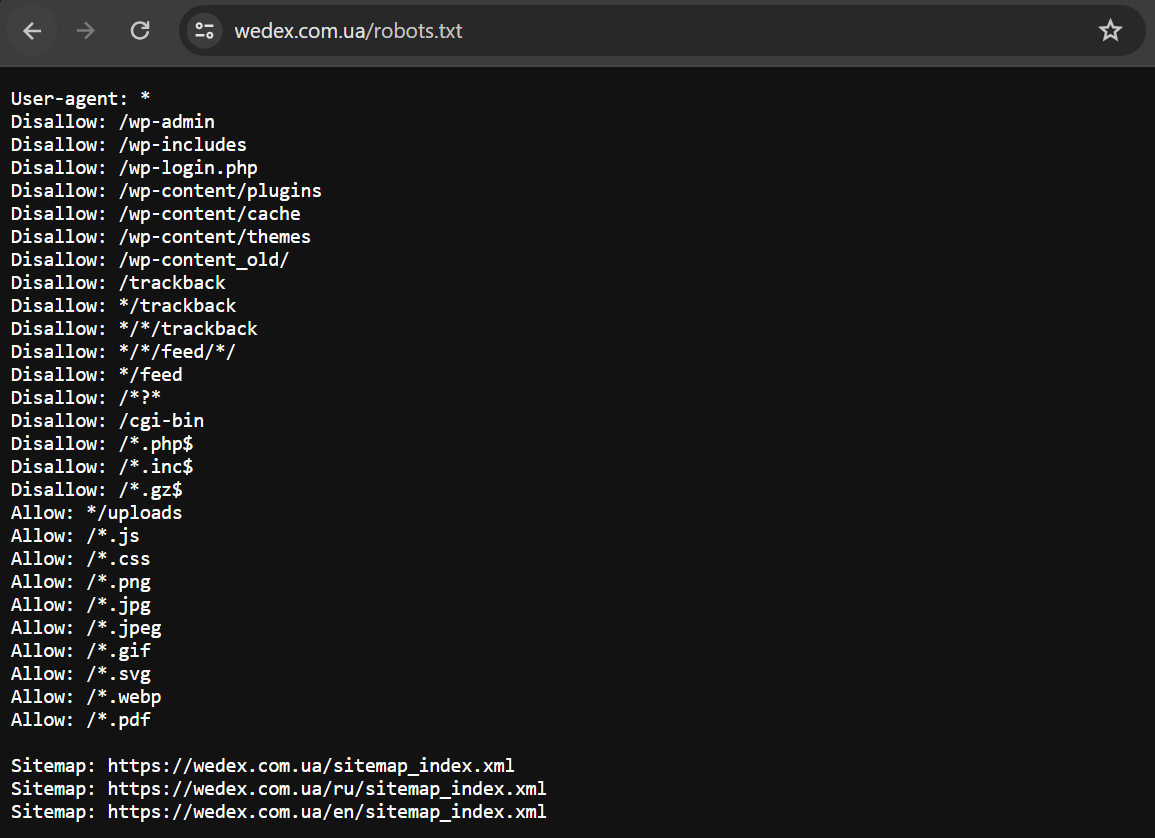

Перевірте файл robots.txt

У пошуку введіть «https://yourdomain.com/robots.txt» та перевірте, чи не заблоковані важливі сторінки для сканування.

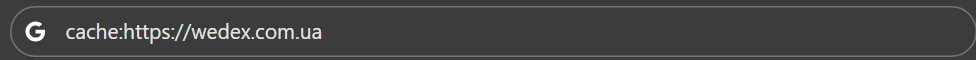

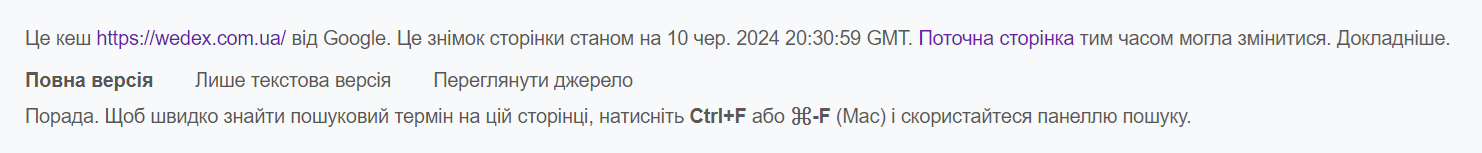

Перевірте кеш сторінок

Google Cache відігравав важливу роль в екосистемі пошуку Google. Його основна функція полягає у створенні та зберіганні копій веб-сторінок, які були проіндексовані пошуковиком. Копії сторінок у кеші були корисні у випадках, коли сайт виявлявся недоступним або не відкривався через територіальні обмеження. Якщо існував кеш сторінки, то це однозначно вказувало на те, що вона була проіндексована. Наразі найстаріша функція Google Кеш відключена і більше не використовується. У видачі посилання на кеш сторінки більше не відображається.

Утім, поки ще можна подивитись кешовану версію сторінки – для цього потрібно ввести префікс «cache:» до URL сайту в адресному рядку. Незабаром зникне і ця можливість.

Це дасть вам змогу побачити останню збережену копію вашої сторінки.

Використовуйте сторонні SEO-програми

Такі інструменти як Ahrefs, SEMrush та Screaming Frog надають інформацію про кількість проіндексованих сторінок, але, на відміну від Search Console, мають платну підписку.

Основні способи пришвидшити індексацію

Прискорення індексації сайту є важливим завданням для кожного SEO-фахівця або власника бізнесу, який прагне підвищити видимість і залучити більше відвідувачів на свій веб-ресурс. Час від створення контенту до його появи у результатах пошуку може впливати на ваш трафік і конкурентоспроможність. У цьому розділі ми розглянемо основні способи, які допоможуть вам покращити процес індексації, забезпечуючи швидке та ефективне відображення вашого контенту в пошукових системах.

Як структура сайту може пришвидшити індексацію

Організована і добре продумана структура допомагає пошуковим роботам легко сканувати ваш сайт, що забезпечує швидку та ефективну індексацію. Розглянемо основні моменти, які сприяють покращенню структури.

Використання чіткої ієрархії сторінок

Ієрархія сторінок є важливою складовою успішної індексації. Логічна і зрозуміла ієрархія допомагає пошуковому роботу краще зрозуміти структуру вашого сайту і його зміст.

- Кожен основний розділ має містити логічні підрозділи та підсторінки. Наприклад, якщо ви продаєте електроніку, ваш основний розділ «Навушники» може мати підрозділи «Sony», «Apple», «Marshall» тощо. Це допомагає робити контент більш доступним і зрозумілим для Google.

- Використовуйте зрозумілі та логічні URL для кожної сторінки. Якщо структура сайту має ієрархічний тип, то URL мають відображати ієрархію сторінок, що полегшує їх сканування.

Створення логічної структури навігації

- Навігація має бути інтуїтивно зрозуміла як для користувачів, так і для пошукових роботів. Це допоможе забезпечити повноцінне сканування всіх важливих сторінок сайту.

- Реалізуйте «хлібні крихти» (breadcrumbs). Це навігаційні елементи, які показують шлях від головної сторінки до поточної. Вони не тільки покращують користувацький досвід, але й допомагають пошуковим роботам зрозуміти структуру вашого сайту.

- Використовуйте внутрішні посилання для зв’язку між сторінками. Це допомагає пошуковим роботам індексувати нові сторінки. Коли ви додаєте нову сторінку на сайт та посилаєтесь на неї з інших сторінок, пошукові роботи швидше дізнаються про її існування і додають її в індекс. Внутрішні посилання також сприяють розподілу ваги (link juice) по всьому сайту, що позитивно впливає на ранжування окремих сторінок.

Використовуйте Sitemap.xml для покращення індексації

Одним із важливих інструментів для покращення індексації є файл Sitemap.xml. Цей файл є своєрідною картою сайту для пошукового алгоритму та допомагає йому швидко знаходити і індексувати сторінки. Файл містить інформацію про URL-адреси вашого сайту, частоту оновлень та пріоритетність сторінок.

Переваги використання Sitemap.xml:

- Коли ви додаєте нові сторінки на свій сайт, вони можуть не відразу з’явитися в індексі пошукових систем. Sitemap.xml дозволяє повідомити пошуковим роботам про новий контент, що прискорює його індексацію.

- Сторінки, які знаходяться глибоко в структурі сайту, можуть мати проблеми зі скануванням. Sitemap.xml допомагає пошуковим роботам знаходити такі сторінки, забезпечуючи їхню індексацію.

- Раніше потрібно було вказувати атрибут частоту оновлень <changefreq> сторінок у Sitemap.xml. Він допомагав пошуковим системам визначати, коли слід повторно індексувати контент. Це було особливо корисно для динамічних сайтів, де контент часто змінювався.

- Також, раніше Sitemap.xml дозволяв вам вказати атрибут пріоритизації <priority> для різних сторінок. Це допомало пошуковому алгоритму зрозуміти, які сторінки для вас важливіші, і забезпечити їх більш швидку індексацію.

Наразі атрибути <priority> і <changefreq> не впливають на сканування та індексування файлів, тому додавати їх у файл sitemap не потрібно.

Як Robots.txt може пришвидшити індексацію

Robots.txt – це текстовий файл, розташований у кореневій директорії вашого сайту, який надає інструкції пошуковим роботам щодо того, які сторінки або розділи сайту можна сканувати, а які – ні. Цей файл використовується для керування доступом до певних частин веб-ресурсу, оптимізуючи тим самим процес індексування.

Переваги використання robots.txt:

- Robots.txt вказує пошуковим системам, які сторінки не повинні бути проскановані. Це може бути корисно для захисту конфіденційної інформації або уникнення дубльованого контенту.

- Пошукові системи мають обмежений ресурс (краулінговий бюджет), який вони витрачають на сканування вашого сайту. Використовуючи robots.txt, ви можете направити ці ресурси на індексацію найбільш важливих сторінок, що підвищує ефективність краулінгу в цілому.

- Іноді на сайті є тимчасові сторінки або сторінки, що знаходяться у розробці. За допомогою robots.txt ви можете запобігти їх індексації до моменту, коли вони будуть готові до публікації.

Швидкість завантаження сторінок

Швидкість завантаження сторінок безпосередньо впливає на користувацький досвід, і навіть затримка в декілька секунд може призвести до втрати відвідувачів. Швидко завантажувані сторінки знижують показник відмов і підвищують тривалість перебування на сайті. Це позитивно впливає на поведінкові фактори, які враховуються пошуковими системами при індексації.

Як підвищити швидкість завантаження сторінок:

- Використовуйте стиснуті формати зображень без втрати якості та адаптивні розміри зображень для мобільних пристроїв.

- Впровадження кешування браузера дозволяє зберігати статичні ресурси на пристрої користувача, зменшуючи час завантаження при повторних відвідуваннях.

- Зменшіть розмір CSS, JavaScript і HTML файлів шляхом мінімізації та об’єднання.

- Використання мережі доставки контенту (CDN) допомагає швидше доставляти контент користувачам по всьому світу.

Використовуйте Indexing API

Indexing API значно покращує індексацію, дозволяючи вебмайстрам миттєво повідомляти пошуковій системі про нові або змінені сторінки, що гарантує швидке включення цих сторінок до індексу. Це зменшує час від публікації до індексації, пріоритизує сканування важливих сторінок, оптимізує бюджет сканування і знижує навантаження на сервер. Таким чином Indexing API покращує SEO-результати, швидко привертаючи органічний трафік і підтримуючи актуальність контенту, що надає сайту конкурентну перевагу.

Як валідний код може покращити індексацію

Валідність коду — це відповідність HTML і CSS стандартам W3C (World Wide Web Consortium). Використання такого коду приносить значні переваги для індексації сайту, забезпечуючи коректне відображення сторінок і полегшуючи роботу пошукових роботів. Він знижує ризик помилок під час сканування та індексації, оптимізує впровадження структурованих даних (schema markup), допомагаючи пошуковим системам краще розуміти контент і підвищуючи шанси на появу у розширених результатах пошуку.

Використовуйте валідний код у комбінації з Semantic HTML, це може покращити ранжування вашого сайту.

Оптимізація під мобільні пристрої

У 2018 році Google впровадив мобільний апдейт (mobile-first indexing), це означає, що пошукова система в першу чергу використовує мобільну версію сайту для індексації та ранжування. Це робить її критично важливою, адже сайти, які не оптимізовані для мобільних пристроїв, можуть втратити позиції у пошуковій видачі.

Розповсюджені помилки під час індексації та як їх уникнути

Правильно виконана індексація дозволяє пошуковим системам знаходити та ранжувати ваш контент, забезпечуючи більше органічного трафіку. Однак існує ряд розповсюджених помилок, які можуть суттєво зашкодити вашій видимості в пошуку. Розглянемо найпоширеніші з них та, як їх уникнути.

- Відсутність файлу robots.txt або його неправильна конфігурація

Файл robots.txt вказує пошуковим системам, які сторінки вашого сайту слід або не слід індексувати. Відсутність цього файлу або неправильна конфігурація можуть призвести до того, що важливі сторінки будуть проігноровані, а менш важливі — проіндексовані.

Як уникнути:

Переконайтеся, що у вас є правильно налаштований файл robots.txt. Вказуйте в ньому лише ті сторінки, які ви хочете закрити від індексації, і дозволяйте індексацію ключових сторінок.

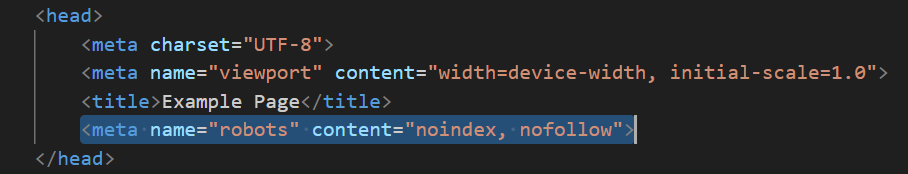

- Використання noindex без обґрунтованої причини

Тег noindex використовується для запобігання індексації певних сторінок. Якщо ви застосовуєте цей тег неправильно, то ризикуєте втратити значний трафік.

Як уникнути:

Застосовуйте тег noindex лише до тих сторінок, які дійсно не мають бути в пошуковій видачі, наприклад, сторінки входу або сторінки з конфіденційною інформацією.

- Наявність дублікатів

Дублікати негативно впливають на індексацію, оскільки пошукові системи не знають, яку версію сторінки відображати в результатах пошуку. Це може призвести до пониження рейтингу всіх дублюючих сторінок.

Як уникнути:

Регулярно перевіряйте свій сайт на наявність дублікатів за допомогою спеціалізованих інструментів, таких як Screaming Frog. Використовуйте тег canonical, щоб вказати основну версії сторінки.

- Відсутність sitemap.xml

Файл sitemap.xml допомагає пошуковим системам швидше знаходити та індексувати всі сторінки вашого веб-сайту. Відсутність цього файлу може уповільнити процес індексації.

Як уникнути:

Створіть і підтримуйте актуальність файлу sitemap.xml. Переконайтеся, що всі важливі сторінки включені в нього, і файл регулярно оновлюється.

- Неправильні канонічні теги

Канонічні теги вказують пошуковим системам на основну версію сторінки, що допомагає уникнути проблем з дублікатами. Неправильне їх використання може збити пошукові системи з пантелику і знизити рейтинг сторінок.

Як уникнути:

Переконайтеся, що канонічні теги встановлені правильно і вказують на основну версію кожної сторінки. Регулярно перевіряйте їхню коректність за допомогою спеціалізованих інструментів: Ahrefs SEO Toolbar, SEOquake та інших.

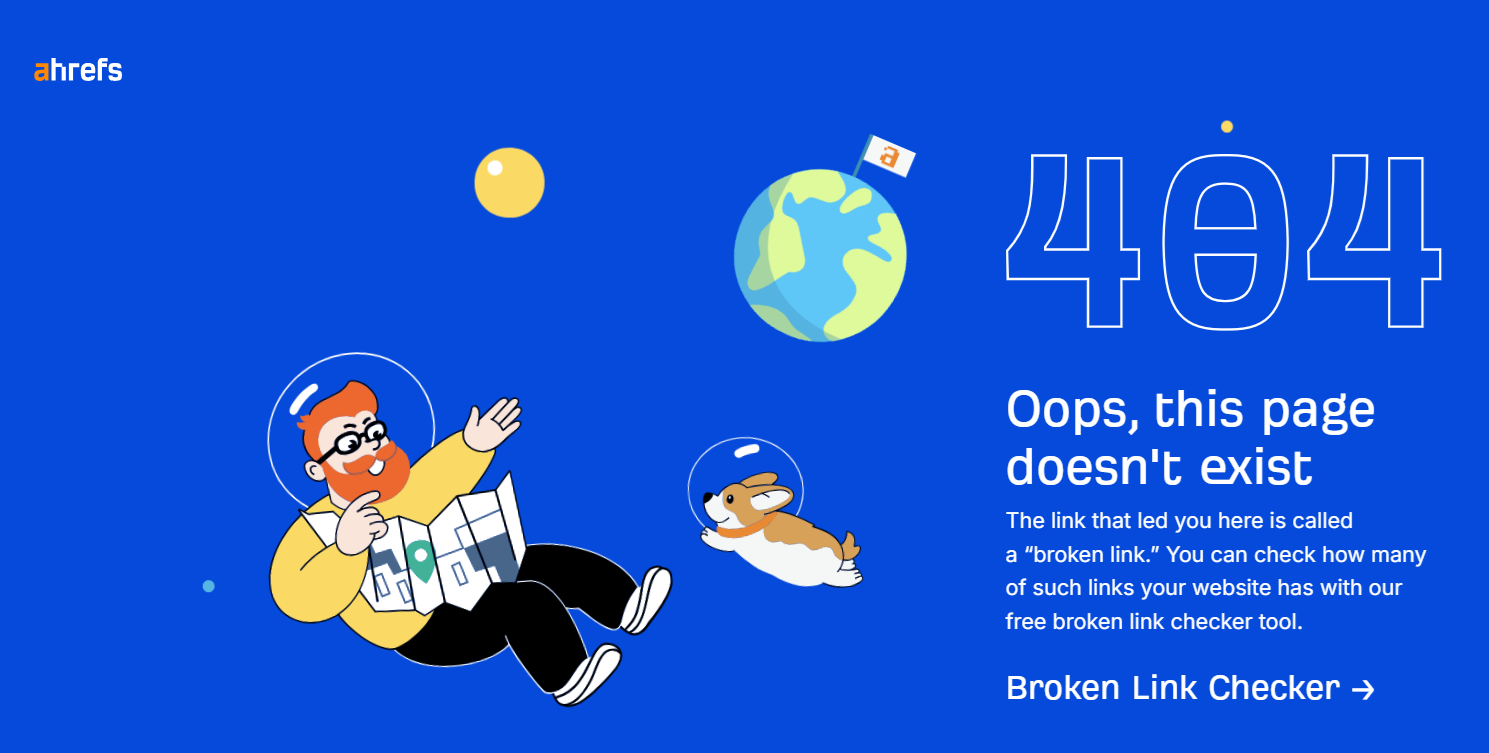

- Помилки 404

Помилки 404 виникають, коли сторінки, які існували раніше, стають недоступними. Це не тільки створює поганий досвід для користувачів, але й негативно впливає на індексацію, оскільки пошукові системи стикаються з мертвими посиланнями.

Як уникнути:

Регулярно моніторте свій сайт на наявність помилок 404 і оперативно їх усувайте. Використовуйте 301 редирект, щоб перенаправляти користувачів і пошукові системи на актуальні сторінки.

- Низька якість сайту

Пошукові системи оцінюють якість сайту на основі контенту, швидкості завантаження, мобільної зручності та багатьох інших факторів. Сайт низької якості може мати низькі позиції в результатах пошуку.

Як уникнути:

Постійно покращуйте якість контенту, оптимізуйте швидкість завантаження, забезпечте мобільну зручність і регулярно оновлюйте сайт. Інвестуйте в дизайн та функціональність, щоб забезпечити позитивний користувацький досвід.

- Проблеми з бюджетом сканування

Бюджет сканування визначає, скільки сторінок вашого сайту буде проіндексовано пошуковими системами. Якщо він використовується неефективно, важливі сторінки можуть залишитися не проіндексованими.

Як уникнути:

Оптимізуйте свій сайт для ефективного використання бюджету сканування. Виключіть з індексації непотрібні сторінки, мінімізуйте використання ресурсів і забезпечте швидке завантаження сторінок.

- Погана внутрішня структура посилань

Пошукові системи покладаються на внутрішні посилання для розуміння структури сайту. Погана структура посилань може призвести до того, що деякі сторінки будуть важкодоступними для індексації.

Як уникнути:

Розробіть логічну і чітку структуру внутрішніх посилань. Використовуйте текстові посилання з релевантними анкорами для покращення видимості важливих сторінок.

- Повільна швидкість завантаження

Повільний сайт не тільки відштовхує користувачів, але й негативно впливає на індексацію, оскільки пошукові системи можуть не встигнути проіндексувати всі сторінки.

Як уникнути:

Оптимізуйте швидкість завантаження сторінок, використовуючи сучасні методи, такі як стиснення зображень, використання кешування та мінімізація коду.

Підведемо підсумки

Індексація є фундаментальним елементом ефективної SEO стратегії. Вона забезпечує видимість вашого контенту в пошукових системах і дозволяє залучати органічний трафік, який є життєво важливим для успіху будь-якого сайту. Розуміння принципів індексації, усунення поширених помилок і використання найкращих практик дозволяє значно покращити ваші позиції в пошукових результатах, що, у свою чергу, призведе до зростання вашого бізнесу.

30/07/2024

30/07/2024  3598

3598